Fiabilité des AB Tests : 3 Règles à Suivre pour Garantir des AB Tests Gagnants

Durée et fiabilité des AB Tests

La durée d’un test AB dépend de la fiabilité de ses résultats. Pour déterminer si un test AB est fiable, il faut prendre en compte plusieurs paramètres statistiques tels la puissance statistique (chi-squared), le niveau de confiance (statistical significance) et la regression vers la moyenne.

Vous vous êtes certainement déjà posé les question suivantes concernant la fiabilité des AB tests que vous avez mis en place :

- Combien de temps doit durer un test AB ?

- Est-ce que les résultats de mes tests AB sont fiables ?

- Est-ce les variations gagnantes des tests AB peuvent être mis en oeuvre sur mon site et est-ce qu’elles vont réellement générer plus de revenus ?

- Est-ce qu’il y a des risques ?

Aujourd’hui je vais vous dévoiler les secrets que beaucoup d’éditeurs de solutions de AB testing préfèreraient garder pour eux !

Sommaire :

[sta_anchor id= »ab-tests-fiables »]Pourquoi la plupart des résultats de tests AB ne sont pas réels ?[/sta_anchor]

Dans le meilleur des cas, vous allez faire des modifications inutiles sur votre site, ou payer une agence web pour les faire, ce qui coûte de l’argent et du temps.

Dans le pire des cas, ces modifications auront même un impact négatif sur vos résultats.

Après avoir lu cet article, vous aurez les clés pour ne pas commettre les mêmes erreurs et assurer la fiabilité des AB tests que vous mettrez en place.

Pour bien comprendre , imaginez la situation suivante :

Supposons que vous ayez une maladie génétique rare (je ne vous le souhaite pas 🙂 ).

Heureusement, des chercheurs a mis au point un médicament pour la guérir et ils sont en train de le tester sur un échantillon de malades.

Mais ce médicament a des effets secondaires forts et les chercheurs souhaitent donc vérifier avec certitude que ce médicament guérit véritablement cette maladie génétique.

À la fin des tests cliniques, vous discutez avec le chercheur :

Le Chercheur : “Nous avons pu démontrer avec un niveau de confiance de 95% que ce nouveau médicament est efficace.”

Vous : “Ça veux dire quoi exactement ?”

Le Chercheur : “Dans seulement 5% des cas, nos résultats de test montrent une amélioration alors qu’il n’y en a pas en réalité.”

Vous : “Ok, mais ce qui m’intéresse véritablement c’est la probabilité que le médicament me guérisse réellement. C’est-à-dire quelle est la probabilité, selon votre test, que ce médicament soit efficace dans la réalité ?”

Le Chercheur : “Ah, ça je ne peux pas vous dire… Je ne sais pas.”

Question : Allez-vous prendre le médicament ? Probablement pas si vous n’avez pas cette information.

Heureusement, les tests AB réalisés en milieu médical sont effectués avec une toute autre rigueur statistique.

Mais ceci n’est malheureusement pas le cas de nombreux test AB qui sont supposés générer davantage de revenus ou d’inscris sur votre site internet.

Beaucoup de responsables marketing se demandent si utiliser un logiciel de AB testing apporte une vraie valeur ajoutée :

“Où sont les 12% d’uplift que j’ai identifié dans mes tests AB ?”,

“Où se trouvent-ils dans mon compte de résultat ?”

Leur test AB a donné une variante gagnante avec un uplift de 12%, mais ceci ne s’est jamais traduit par plus de revenus ou plus de profits.

Alors que s’est-il passé ?

[sta_anchor id= »regles-ab-tests »]3 règles à suivre impérativement pour assurer la fiabilité des AB tests[/sta_anchor]

Lorsque vous faites du AB testing, il faut suivre 3 règles importantes pour assurer la fiabilité des AB tests afin de mettre en oeuvre définitivement ces changements sur votre site internet :

1. Vérifiez la puissance statistique d’un AB test (“statistical power”)

2. Vérifiez la représentativité statistique de vos AB tests (« statistical significance »)

3. Vérifiez la régression vers la moyenne de vos AB tests

Note : n’ayez pas peur si vous n’êtes pas statisticien, je vais vous donner les clés pour être sûr que vos résultats de test ne seront pas qu’une illusion, et ceci de manière si simple que même votre fille de 15 ans pourrait le comprendre.

En appliquant ces 3 règles, vous pourrez significativement augmenter la fiabilité des AB tests que vous lancez et vous observerez que la grande majorité de vos AB tests auront un véritable impact dans la réalité.

Et vous ne vous demanderez plus : “Où sont les 12% d’uplift que j’ai identifié dans mes AB tests ?”

[sta_anchor id= »puissance-statistique »]1. Vérifiez la puissance statistique de vos test AB (Statistical Power)[/sta_anchor]

Le calcul de la puissance statistique (pour les statisticiens : 1 – beta) est l’un des éléments les plus importants dans la fiabilité des AB tests que vous mettez en place, pour savoir si les résultats de vos tests AB peuvent justifier de mettre en place les changements testés, et ce définitivement.

Pourtant, la quasi-totalité des éditeurs de logiciels de AB Testing n’en parlent pas.

Et pour cause :

Presque tous les Tarifs de AB Testing standards n’offrent pas un volume suffisant pour obtenir des résultats de test qui ont une forte chance de se reproduire dans la réalité.

Le volume de visiteurs inclus dans les plans standards est généralement inférieur à la taille de l’échantillon pour un AB Test, donc trop basse pour atteindre une puissance statistique suffisamment élevée. La fiabilité des AB tests est donc remise en question.

Le calcul de la taille de l’échantillon nécessaire pour un test statistique est plus connu sous le nom de calcul de la puissance statistique.

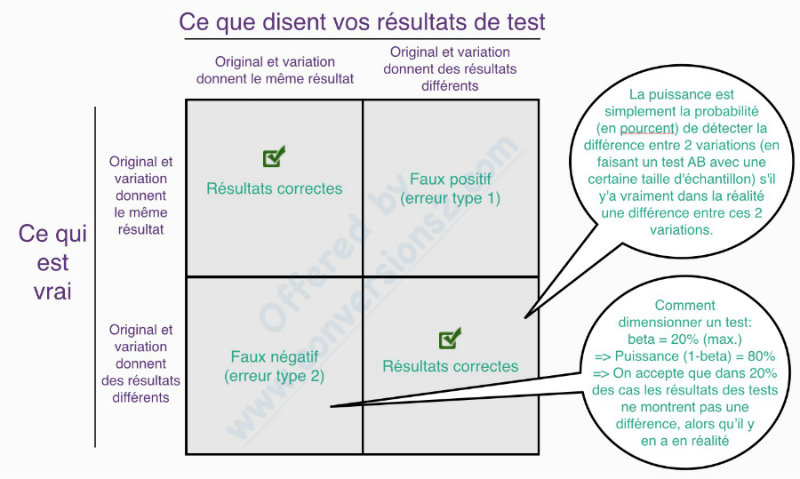

La puissance (1 – beta) est simplement la probabilité en pourcentage, de détecter une différence entre 2 variations, en faisant un AB test avec une certaine taille d’échantillon, si cette différence existe vraiment dans la réalité.

En règle générale, on considère qu’un AB test a suffisamment de “puissance” si celle-ci est supérieure ou égale à 80% (pour les statisticiens parmi vous : la puissance est la probabilité de rejeter une hypothèse nulle si celle-ci est fausse).

Pourquoi pas plus que 80% me direz-vous ?

Si vous avez suffisamment de trafic, vous pouvez passer à 90%. Mais le problème est qu’avec 90% vous ne pouvez souvent plus faire d’AB test, simplement parce que la plupart des sites internet n’ont pas assez de trafic.

Clarifions le terme “variations”: si je parle de 2 variations, c’est qu’il y a une variante de “contrôle”, qui est traditionnellement votre page web actuelle et une variante modifiée, qui est la variation que vous souhaitez tester par rapport au contrôle.

Plusieurs facteurs influencent la puissance statistique :

- La taille d’échantillon de votre AB test (le nombre de visiteurs qui voient les 2 variations dans un AB test). Donc taille trop faible -> puissance faible -> Fiabilité des AB tests remise en question.

- La différence de taux de conversion observée entre les 2 variations : Si la différence de taux de conversion observée est faible -> il faut un échantillon plus important pour garder la même puissance.

- Si votre AB test est unilatéral ou bilatéral : Si vous ne faites qu’un test unilatéral vous ne pouvez constater qu’une augmentation du taux de conversion entre 2 variations, mais pas une diminution. La fiabilité des AB tests que vous effectuez n’est donc pas au rendez-vous. Vous voulez aussi savoir si vos modifications peuvent avoir un effet négatif sur vos taux de conversion. C’est pour cela que nous voulons faire des AB tests bilatéraux. Un AB test bilatéral fait diminuer la puissance par rapport à un test unilatéral, toute chose étant égale par ailleurs.

- La représentativité statistique (ou statistical significance) de votre test (alpha) : je vous en reparlerai plus tard. Elle vous permet de calculer le niveau de confiance de votre test (1 – alpha). Sachez cependant que plus la confiance est faible, plus votre puissance augmente. Mais nous voulons aussi un niveau de confiance élevé afin de garantir la fiabilité des AB tests mis en place… il existe bien évidemment des solutions que je vous montrerai un plus loin dans cet article.

Alors pourquoi la puissance statistique est-elle si importante ?

Premièrement, si votre AB test n’a pas assez de puissance, c’est-à-dire si vous n’avez pas assez de trafic pour arriver à un seuil de 80% de puissance, vous augmentez le risque de ne constater aucun changement de votre taux de conversion, alors qu’en réalité, il y en a un (Erreur Type 2 dans l’image ci-dessous) !

Mais il existe un effet encore bien plus néfaste.

Plus votre puissance statistique diminue, plus les variantes “gagnantes” que vous allez voir à l’issue d’un AB test avec une puissance trop basse ont des chances d’être des “faux positifs”. C’est-à-dire que vous pensez avoir un gagnant, mais en réalité il ne génère aucune augmentation de revenus ou d’abonnés.

Votre AB test risque alors d’être un gaspillage de temps et d’argent.

D’où l’importance de calculer correctement le nombre de visiteurs de chacune des variations dans un AB test avec une puissance statistique d’au moins 80%. Vous pouvez le calculer en utilisant AB Test Guide , qui a été créé par des experts en optimisation au Pays Bas, dont Ton Wesseling). Tout y est expliqué ici.

Voici deux autres éléments qui devraient vous faire réfléchir :

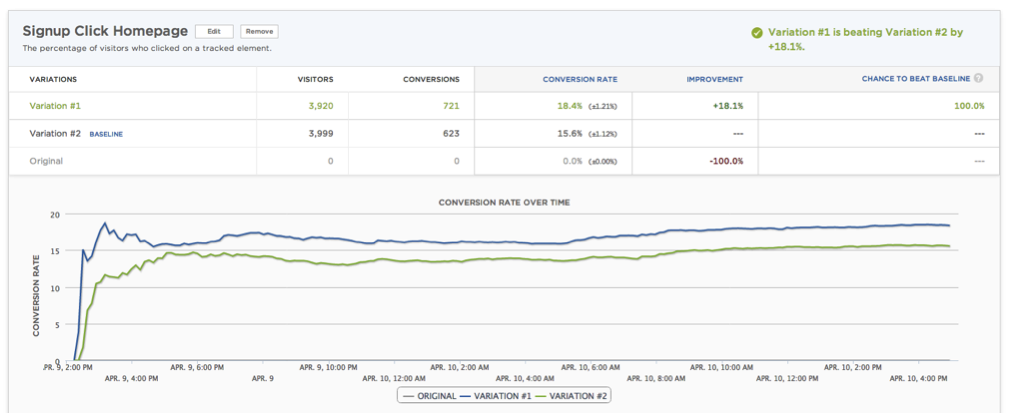

Peter Borden de sumall.com a partagé les résultats d’un test AA, c’est-à-dire que la page de contrôle et la variation sont strictement identiques. Les résultats identifient un gagnant avec 18,1% d’uplift, et la chance de “battre la baseline” est de 100% :

Si vous n’utilisez pas correctement votre outil de AB testing, i.e. en assurant une puissance statistique élevée, vous aurez beaucoup de “faux gagnants”.

Ton Wesseling, fondateur de Testing Agency , est un des rares vrais experts en testing. Il affirme la chose suivante :

“Vous devriez savoir qu’arrêter un test une fois qu’il a atteint la représentativité statistique est le pêché No 1 dans le domaine de l’AB testing. 77% de tests AA (même page vs même page) atteignent la représentativité statistique choisie à un moment.”

Il ajoute:

“Vous souhaitez tester aussi longtemps que possible – au moins un cycle d’achat. Plus vous avez de données, plus la puissance statistique de votre AB test sera élevée ! Plus de trafic signifie que vous avez une plus grande chance de reconnaître votre gagnant en vous basant sur le niveau de représentativité statistique que vous avez fixé pour votre test ! Parce que … les petits changements peuvent avoir un impact important, mais les grands impacts ne se produisent pas très souvent. La plupart du temps, votre variation est légèrement meilleure. Vous avez alors besoin de beaucoup de données pour pouvoir obtenir un gagnant significatif.”

[sta_anchor id= »representativite-statistique »]2. Vérifiez la représentativité statistique (statistical significance) de vos AB tests[/sta_anchor]

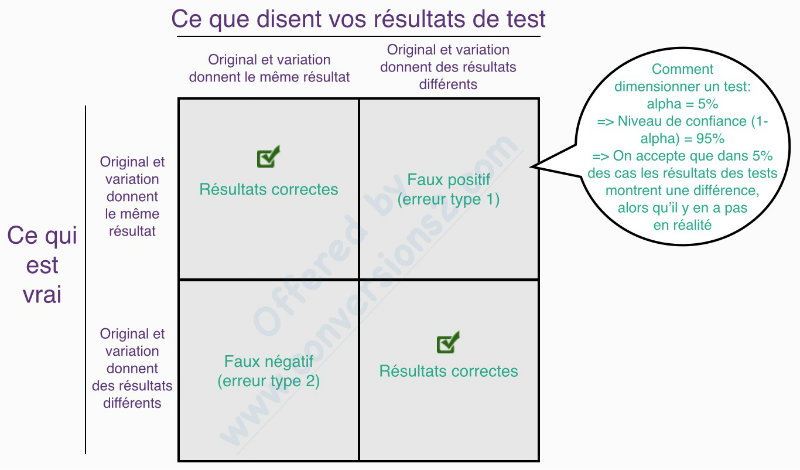

C’est là notre règle numéro 2 permettant d’assurer la fiabilité des AB tests que vous mettez en place. Il s’agit de la probabilité, en pourcentage, que les résultats de vos AB tests montrent une amélioration, alors qu’il n’y en a pas en réalité. C’est ce qu’on appelle un “faux positif” (pour les statisticiens : la probabilité de ne pas rejeter l’hypothèse nulle, alors que celle-ci est vraie !)

Nous voulons évidemment créer un AB test avec la représentativité statistique la plus basse possible.

La représentativité statistique (pour les statisticiens : c’est le “alpha” = erreur de type 1) est un terme qui peut prêter à confusion :

Dans les solutions d’AB testing on parle souvent “d’indice de confiance”, “d’intervalle de confiance” ou “de niveau de confiance” (confidence level).

Ce niveau de confiance est égal à (1- alpha) ! On établit traditionnellement un niveau de confiance à 95% afin de garantir une certaine fiabilité des AB tests . C’est-à-dire qu’on accepte que dans 5% des cas (c’est la représentativité statistique) nos résultats de test montrent une amélioration, alors qu’il n’y en a pas en réalité.

C’est ce “niveau de confiance” sur lequel se basent beaucoup de marketeurs et beaucoup de solutions d’AB testing.

Mais voyez-vous le problème ?

Référez-vous encore une fois à notre “chercheur” ci-dessus.

Certes, il est important de limiter le nombre de “faux positifs” dans un AB test, mais il est bien plus important encore de s’assurer avec une probabilité élevée que ce que vous avez détecté dans votre AB test reflète la réalité afin d’assurer la fiabilité des AB tests que vous attendez. Et pour cela, un bon niveau de puissance statistique est plus important qu’un bon niveau de confiance.

Lorsque vous utilisez AB TestGuide, choisissez alors 95% de “Confidence level” et 80% de “Power”.

Avec ces règles vous réduisez les erreurs de type 1 (détecter un uplift qui n’en est pas un dans la réalité) ET les erreurs de type 2 (ne pas détecter d’uplift qui est pourtant réel, avec votre AB test).

[sta_anchor id= »regression-vers-la-moyenne »]3. Est-ce que vous observez une régression vers la moyenne de vos résultats de tests[/sta_anchor]

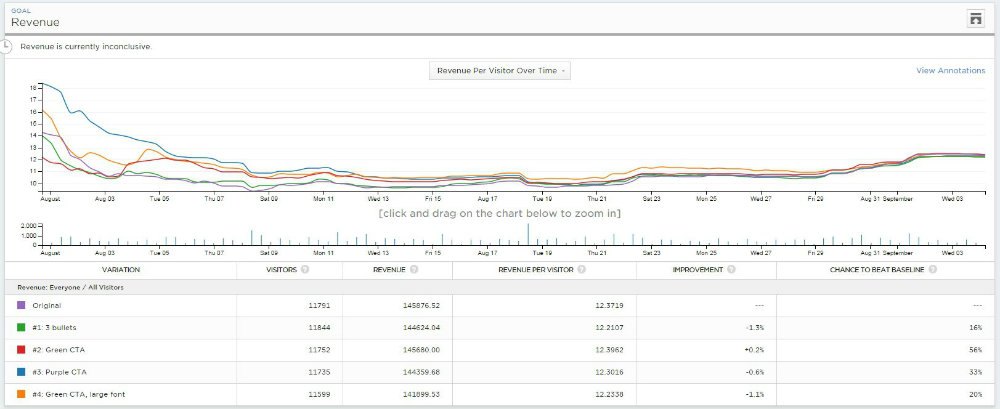

Si vous avez fait une multitude d’AB tests vous êtes certainement tombé sur ce type de scénario :

Au départ (1 semaine après le lancement du test pour un site à fort trafic, 3 ou 4 semaines après pour un site avec un trafic plus faible) vous avez un gagnant net, mais en attendant un peu, l’uplift que vous avez observé disparaît.

Voici un exemple de Peep Laja, co-organisateur du Digital Elite Camp. C’est l’exemple parfait pour illustrer ce propos :

Vous êtes tenté d’arrêter cet AB test après 2 semaines ?

La variation 4 gagne d’une dizaine de % !

Mais regardez ce qu’il se passe à la fin. Aucune différence.

Restez extrêmement sceptique si vous observez un de vos tests AB dont les résultats se dégradent dans le temps. Mais aussi lorsque la performance se dégrade lors d’un deuxième test AB de validation.

Je pense que ces résultats reflètent simplement un faux positif. Le fait que l’uplift disparaisse dans le temps est très probablement dû au fait qu’il n’y avait pas d’uplift au départ 🙂 .

En statistique on appelle ceci la régression vers la moyenne. Mais malheureusement, beaucoup de CRO Manager ne connaissent pas cette notion.

Sur Wikipedia on trouve un exemple très concret pour illustrer cet effet :

Imaginez que vous êtes professeur et que vous donnez un test à vos étudiants avec 100 questions nécessitant une réponse vrai / faux. Aucun étudiant n’est préparé (mais ça, vous ne le savez pas) et tous répondent complètement au hasard à toutes les questions. Chaque étudiant aura alors un résultat complètement aléatoire entre 0 et 100 bonnes réponses avec une moyenne sur tous les étudiants de 50.

Les dix meilleurs étudiants auront une moyenne bien supérieure à 50 bonnes réponses. Ce sont vos “gagnants”. Si vous leur donnez un second test du même type et s’ils répondent toujours de façon aléatoire (vous ne le savez toujours pas), le nombre de bonnes réponses qu’ils vont donner sur ce second test sera inférieur au premier. Ceci parce que complètement indépendamment de leurs “bons” résultats lors du premier test, la moyenne sera toujours de 50 bonnes réponses lors du second test… logique.

Vous allez alors conclure, incorrectement, que les étudiants maîtrisent moins bien leur sujet avec le temps.

La même chose arrive si vous faites de l’AB testing. Si votre gagnant a été un faux positif, chaque test ultérieur du même type réduira l’uplift en conversion que vous allez obtenir avec votre variation. À l’inverse, si vous aviez fait durer le test plus longtemps, l’uplift aurait disparu.

Conclusion :

Si vous observez des AB tests qui ne semblent pas garder leur différentiel de taux de conversion dans le temps, posez-vous la question : Ai-je été rigoureux dans la conduite de mon test ? le test avait-il une puissance statistique suffisamment élevée (≥ 80%) ?

Si vous n’êtes pas certain, refaites un 2ème AB test de validation avec un trafic par variante correctement choisi (voir AB TestGuide).

Enfin, si vous n’avez pas assez de trafic afin de finaliser votre test en 8 semaines maximum, voici quelques conseils à suivre :

- Allongez éventuellement la durée de vos AB tests à 3 mois en acceptant un certain degré de pollution, lié entre autres à la suppression de cookies chez vos visiteurs.

- Travaillez votre Proposition de Valeur et mettez-la en place.

- Apportez des changements “novateurs” à vos Landing Pages en utilisant les dernières recherches en neurosciences et utilisez un spécialiste dans le domaine du neuromarketing.

- Apprenez-en plus sur vos visiteurs et clients en utilisant des techniques telles que le User Testing, les outils de Heatmaps, les outils de Scrollmaps, le Visitor Recording, les Mini Surveys etc.

- Effectuez des tests fonctionnels. Testez plusieurs pages de votre site sans oublier le funnel de conversion (achat/inscription etc.), et assurez-vous que tout marche correctement et sur tout type de navigateur, appareil…

- Travaillez avec un spécialiste de l’analyse heuristique de votre site.

[sta_anchor id= »garantir-test-fiable »]Conclusion – Que faire pour garantir la fiabilité de vos AB tests ?[/sta_anchor]

Récapitulons ce que vous devez faire afin de garantir la fiabilité des AB tests que vous mettrez en place dans le futur.

- Assurez-vous avant de lancer votre AB test que vous avez un trafic suffisant

- Établissez une puissance statistique pour vos AB tests de 80% minimum

- Utilisez un niveau de confiance pour vos AB tests de 95%

- Avant d’arrêter un AB test, revérifiez et laissez toujours votre test actif par semaine complète

- N’hésitez pas à refaire un second test de validation pour confirmer les résultats de vos AB tests

Dans un prochain article je vous donnerai plus de détails sur ce que vous pouvez faire très concrètement si votre site a trop peu de trafic.

Et si vous souhaitez un avis personnalisé pour votre site, sur la fiabilité des tests que vous avez effectué ou encore savoir comment mettre un AB test correctement en place dans VOTRE contexte, contactez-nous.